TOP 04 CÔNG NGHỆ HỖ TRỢ QUẢN LÝ DỮ LIỆU LỚN CHO DOANH NGHIỆP

20/01/2022 |

1472

1472

Bước vào năm 2022 là thời đại của kỹ thuật số và nhu cầu lưu trữ và tận dụng các nguồn dữ liệu (Big data) ngày càng lớn. Và dữ liệu lớn trở thành một trong bốn nền tảng của cuộc cách mạng công nghệ 4.0.

Dữ liệu lớn (Big Data) đã trở thành nền tảng quan trọng của cuộc cách mạng công nghệ 4.0. cùng với IOT (Internet vạn vật), AI (Trí tuệ nhân tạo), Chuỗi khối (Blockchain). Big Data được hiểu là dữ liệu khổng lồ, nguồn tài sản thông tin có dung lượng lớn, đa dạng, tốc độ và hình thức xử lý thông tin giúp tiết kiệm chi phí để nâng cao hiệu quả công việc, ra quyết định và tối ưu hóa quy trình. Có thể hiểu đơn giản dữ liệu lớn là một tệp dữ liệu khổng lồ không thể phân tích được bằng các công cụ và phần mềm thông thường.

Tầm quan trọng của dữ liệu lớn

Tầm quan trọng của dữ liệu lớn không phải từ lượng dữ liệu mà chúng ta có, mà nằm ở việc bạn làm gì với nó. Các doanh nghiệp, tổ chức đều sử dụng nguồn dữ liệu lớn phân tích để trả lời cho các câu hỏi: Giảm chi phí, giảm thời gian, phát triển sản phẩm mới và dịch vụ tối ưu, ra quyết định thông minh.

Khi việc phân tích nguồn dữ liệu lớn được tối ưu hóa, doanh nghiệp có thể thực hiện tốt các tác vụ như:

- Xác định nguyên nhân gốc rễ của những lỗi, khuyết điểm trong thời gian dài;

- Tạo các chiến dịch khuyến mại hiệu quả dựa trên thói quen của khách hàng;

- Tính toán được những rủi ro, phát hiện hành vi gian lận trước khi nó có ảnh hưởng.

Việt Nam là một trong 20 quốc gia có số lượng người dùng Internet lớn nhất thế giới. Theo thống kê của Tổng cục Thống kê, tỷ lệ truy cập của cư dân mạng năm 2019 là 68,7%. Trong khi đó, mức trung bình của thế giới là 51,4%. Do đó, các chuyên gia cho rằng thị trường dữ liệu lớn của Việt Nam là thị trường hàng đầu châu Á.

Phân tích dữ liệu là gì?

Phân tích dữ liệu (Data Analytics) là một chuyên ngành trong Công nghệ thông tin. Công việc tập trung vào việc thu thập, khai thác, quản lý và xử lý bộ dữ liệu – các Big Data, từ đó đưa ra các nhận định, dự đoán xu hướng hoạt động của tương lai. Phân tích dữ liệu có thể bao gồm phân tích dữ liệu thăm dò, phân tích dữ liệu xác nhận, phân tích dữ liệu định lượng và phân tích dữ liệu định tính (tập trung vào các dữ liệu như video, hình ảnh và văn bản).

Việc xử lý dữ liệu có ý nghĩa rất quan trọng đối với bất kỳ tổ chức hoặc doanh nghiệp nào. Các lĩnh vực hiện đang cần có nguồn dữ liệu phân tích chính xác như: Ngân hàng đầu tư, bảo hiểm, du lịch, quốc phòng, hàng không vũ trụ và y học, bán lẻ,...v.v....

Qua bài viết này, quý bạn đọn hãy cùng chúng tôi tìm hiểu về các công cụ mã nguồn mở giúp phân tích Big Data hiệu quả trong năm 2022.

#1 Xplenty

Đây là một nền tảng để tích hợp, xử lý và chuẩn bị dữ liệu cho phân tích trên đám mây. Phần mềm sẽ tổng hợp tất cả các nguồn dữ liệu của bạn lại. Giao diện đồ họa trực quan của Xplenty sẽ giúp bạn triển khai ETL, ELT hoặc giải pháp nhân rộng.

Xplenty là bộ công cụ hoàn chỉnh để xây dựng pipelines dữ liệu với khả năng mã thấp và không cần mã. Công cụ còn là giải pháp hiệu quả cho Marketing, bán hàng, và các nhà phát triển.

#2 Apache Hadoop

Apache Hadoop được đánh giá là công cụ xử lý dữ liệu lớn hàng đầu. Trên thực tế, hơn một nửa trong số 50 công ty trong danh sách Fortune sử dụng Hadoop. Một số cái tên tiêu biểu: Amazon Web services, IBM, Intel, Microsoft, Facebook, v.v. Đây là một khung phần mềm được sử dụng cho hệ thống tệp được phân cụm và xử lý dữ liệu lớn. Phần mềm xử lý khối dữ liệu bằng mô hình lập trình MapReduce. Hadoop là một khung mã nguồn mở được viết bằng Java và nó cung cấp hỗ trợ đa nền tảng.

#3 Lumify

Lumify là một công cụ mã nguồn mở và miễn phí để tổng hợp / tích hợp, phân tích và trực quan hóa dữ liệu lớn.

Công cụ cung cấp nhiều tính năng bao gồm: Tìm kiếm toàn văn bản, trực quan hóa đồ thị 2D và 3D, bố cục tự động, tích hợp với hệ thống lập bản đồ, phân tích không gian địa lý, phân tích đa phương tiện, tính năng Space cho phép người dùng tổ chức công việc thành tập hợp các dự án hoặc workspace.

#4 Cassandra

Apache's Cassandra cũng là một công cụ miễn phí cho doanh nghiệp sử dụng. Phần mềm nguồn mở được xây dựng để có thể quản lý khối lượng lớn dữ liệu nhờ vào NoSQL DBMS. Thậm chí có thể xử lý dữ liệu đã được phân phối trên nhiều loại máy chủ hàng hóa khác nhau. Công cụ có CQL (Ngôn ngữ cấu trúc Cassandra) riêng để tương tác với cơ sở dữ liệu của nó. Cassandra đã được một số công ty nổi tiếng săn đón vì nó hoạt động tốt như thế nào. Các công ty lớn American Express, Accenture, Yahoo, General Electric và Honeywell đều sử dụng công cụ này. Một nhược điểm của công cụ là tốn nhiều thời gian để khắc phục sự cố và bảo trì hơn một chút so với các công cụ khác. Nhưng với mức giá miễn phí thì Cassandra xứng đáng để doanh nghiệp sở hữu.

Kết luận:

Trên đây là top các công cụ phân tích dữ liệu hiệu quả mà Vitranet24 tổng hợp và đánh giá lại từ các chuyên gia và người dùng. Chúng tôi hy vọng doanh nghiệp có thể lựa chọn được công cụ phù hợp tùy thuộc vào mục đích của mình.

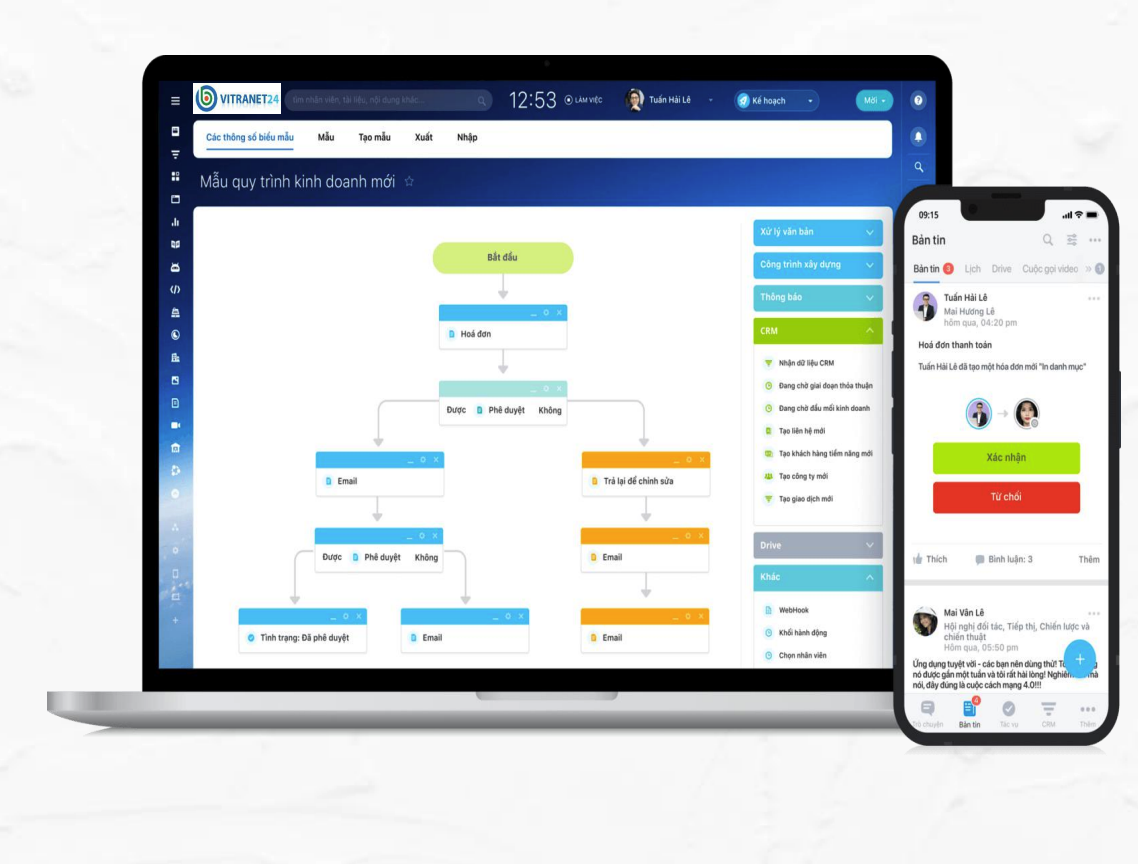

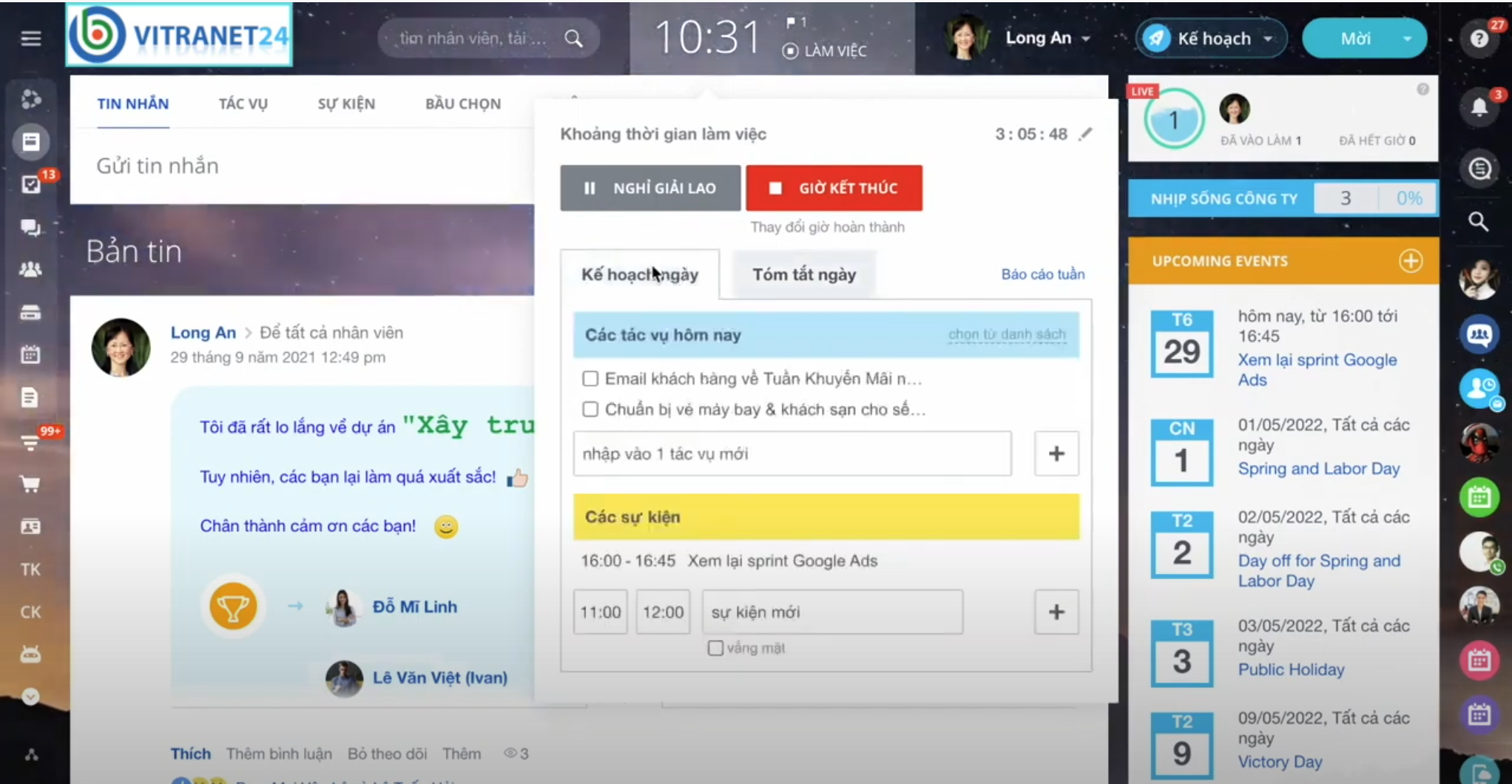

Quý doanh nghiệp có nhu cầu tìm hiểu hoặc được tư vấn về các giải pháp số hóa, phần mềm quản lý công việc hiệu quả trong cuộc cách mạng chuyển đổi số 4.0. Xin vui lòng liên hệ với Vitranet24 theo địa chỉ: https://vitranet24.com/san-pham-dich-vu/eoffice/

Tổng hợp nguồn từ vssmonitoring, softwaretestinghelp, v..v..

★★★★★

0/5 - (0 bình chọn) Click để đánh giá

★★★★★

Like Bản tin Vitranet24

Phần mềm giúp đơn vị truyền tải thông tin nhanh chóng

Chương trình giảm giá "phép thuật" tới 35% từ Bitrix24...

Vitranet24 cam kết sẽ bảo mật những thông tin mang tính riêng...

Ngày 23/06/2025, Tổng công ty V&V – Vitranet24 vinh dự đồng...

Chuyển đổi số không còn là xu hướng, mà là yếu tố sống còn...

Theo nghiên cứu được công bố ngày 30/10 trên Nature Computational...

Tiếng Anh

Tiếng Anh Tiếng Việt

Tiếng Việt